Circa un anno fa, mentre cercavo di fare la mia parte nella primavera silenziosa del governo aperto in Italia, ho fatto una scoperta straordinaria: grandi organizzazioni autorevoli che raccolgono e diffondono dati economici e sociali li stavano rilasciando in formati aperti. Questi dati sono molto rilevanti per quello che faccio nella vita: setacciare informazione per costruire modelli di mondo localmente rilevanti, sulla base dei quali agire in direzione di qualche forma di miglioramento nel nostro ambiente sociale ed economico. I dati, naturalmente, sono una forma di informazione. Improvvisamente ce n’erano molti: Banca Mondiale, OCSE, Eurostat e altri si erano messi a pubblicare grandi basi dati scaricabili. Ho passato un po’ di tempo a familiarizzarmi con gli strumenti di preview e di analisi completa messi a disposizione da queste organizzazioni: alcuni sono più intuitivi di altri, ma in generale la cosa mi è sembrata noiosa e dispendiosa in termini di tempo. È così che ho cominciato a preoccuparmi che la gente potesse trovare il tutto troppo complicato, e finisse per non usare affatto i dati: viene da qui la mia ossessione per stimolare la domanda di dati e la data literacy.

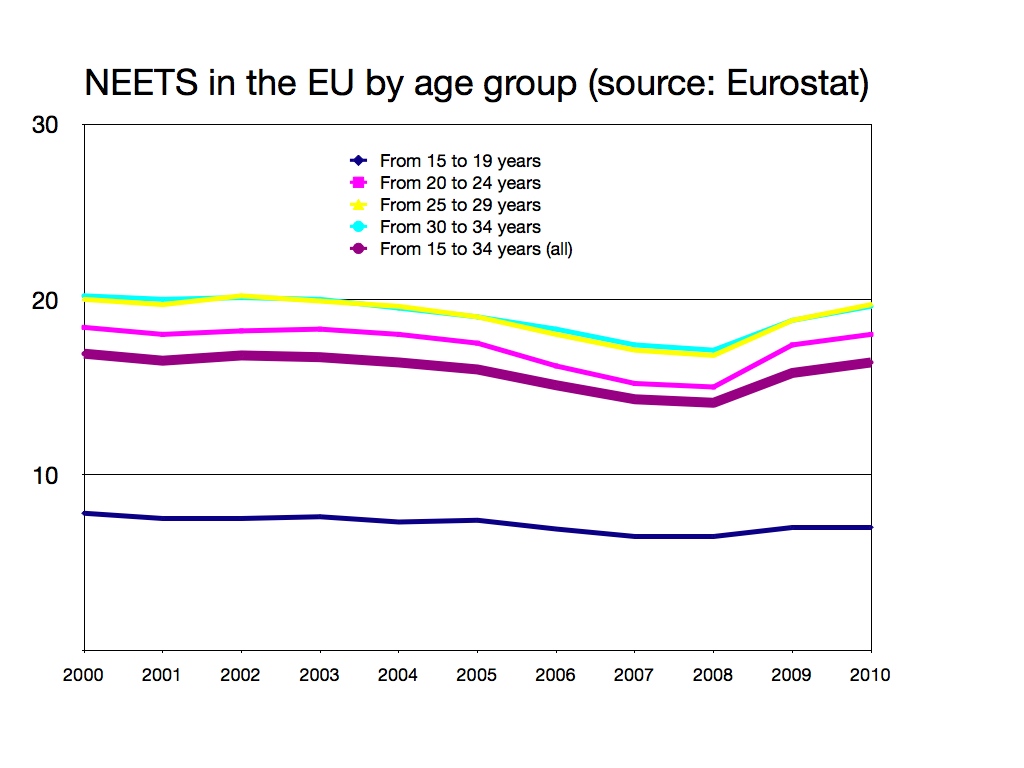

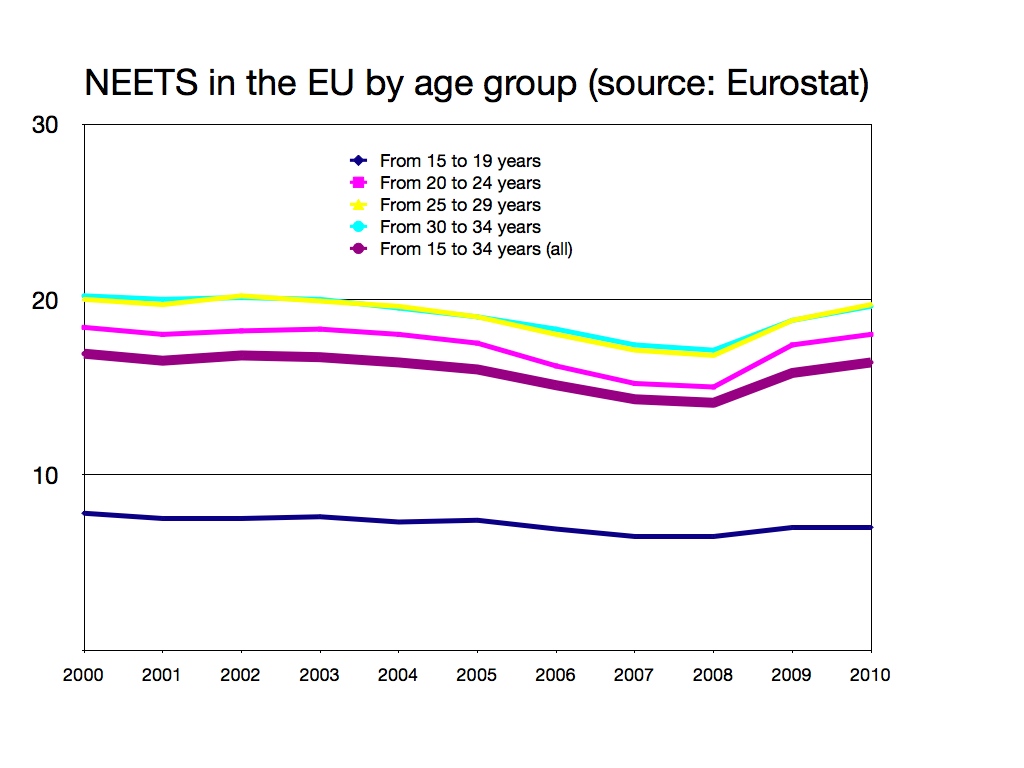

Pare che abbia sopravvalutato le difficoltà di interagire con i dati aperti. Qualche settimana fa avevo bisogno di alcuni dati che riguardano i giovani europei non occupati e non impegnati nella scuola, nell’università o nella formazione professionale (NEETs). Mi sono accampato sul sito di Eurostat e, con un po’ di tentativi, errori e conversioni di file sono riuscito a produrre il grafico tutto colorato che vedete qui sopra. L’ho fatto in modo che indicasse a me e ai miei colleghi una storia piuttosto potente, e cioè che la transizione dalla parziale indipendenza dell’adolescenza alla piena indipendenza della vita adulta è diventata così lunga e difficile che il concetto di “giovani” si sta sfaldando in una diminuzione generale dell’autonomia della popolazione adulta. Il mio lavoro è stato reso molto più semplice dal pre-filtraggio online dei dati: invece di farmi scaricare tutto il database, Eurostat mi ha permesso di selezionare gli indicatori, i paesi e gli anni che mi interessano. Una volta soddisfatto, ho cliccato “download”, e il sistema ha generato per me un file che contiene solo quelli. È più difficile che, poniamo, guardare Captain America, ma molto più semplice che non scartabellare pagine di tabelle.

Questo mi ha fatto pensare a come nuovi strumenti abbiano rivoluzionato la professione di economista già due volte nell’arco della mia vita. Quando ho iniziato a lavorare nel 1991, ero parte della prima generazione di ricercatori che non ha mai fatto ricerca senza i personal computer. Gli istituti di ricerca avevano ancora segretarie per battere e rilegare i rapporti finali (anche se quei posti di lavoro si stavano rapidamente liquefacendo); i miei colleghi più anziani avevano prodotto un sacco di risultati solidi usando mainframes, calcolatrici e macchine da scrivere. Di uno di loro si diceva che avesse invertito una matrice 20×20 a mano per fare l’analisi input-output di un’economia locale. Un anno dopo, a Londra, ho visto per la prima volta il terminale di un computer connesso a Internet; nel 1994 era diventato normale, per gli economisti, trasmettersi documenti in formato digitale da una parte all’altra del pianeta.

I dati aperti potrebbero essere la prossima rivoluzione in questo senso. I non-quantitativi come me sono abituati a rivolgersi a uno statistico per qualunque cosa vada oltre il copia-e-incolla di grafici e tabelle prodotti da qualcun altro. I dati aperti e il software a buon mercato per la statistica e la visualizzazione stanno cambiando questa situazione: qualcuno come me, che capisca un po’ di statistica ed econometria, può provare a montare semplici modelli di regressione al volo, trasformandosi da lettore a produttore di dati elaborati. Quando troviamo qualcosa di promettente, possiamo sempre rivolgerci allo statistico perché ci lavori sopra di fino. I benefici sono evidenti: più intuizioni possono essere sottoposte a un reality check rapido, anche se rozzo; e man mano che interagiamo con i dati, ci ritroviamo a cercare articoli di Wikipedia su cose come misure di fit o logit multinomiali. Diventiamo più bravi a elaborare i dati, e quindi a interpretare i dati elaborati da altri. È plausibile che la prossima generazione di ricercatori userà i dati aperti tutti i giorni, come oggi usiamo Google, e si chiederà come facessero quei poveri diavoli negli anni 2000 (noi) a farne a meno. Proprio come faccio io quando penso al mio collega con la sua matrice 20×20 da invertire a mano.